Gerardo Iovane

Docente Universitario di Analisi Matematica presso il Dipartimento di Ingegneria dell’Informazione e Matematica Applicata dell’ Università degli Studi di Salerno.

Docente di Biometria ed Identificazione per il Corso di Laurea in Informatica presso la Facoltà di Scienze MM.FF.NN. dell’Università di Messina.

1. Introduzione

Alla base delle nuove minacce di cyberwarfare troviamo l’evoluzionismo informatico e la genetica dei numeri primi. Il primo condurrà la Comunità Internazionale ad affrontare minacce a livello sistemico in cui lo spazio virtuale e quello fisico non saranno disaccoppiati come accade oggi, bensì dal palmare o da un notebook sarà possibile comandare dispositivi di tipo wireless a distanza di migliaia di chilometri.

La genetica della primalità mette a nudo, invece, una possibile intrinseca fragilità dei sistemi di sicurezza su cui abbiamo costruito negli ultimi decenni la gran parte dell’apparto tecnologico per la cifratura e la riservatezza delle informazioni.

Nell’immediato futuro si dovranno, pertanto, porre in essere misure di prevenzione e contrasto ad un cyberterrorismo che è in relazione al cyberterrorismo attuale allo stesso modo in cui gli artisti di strada del XV secolo erano in relazione con la grande arte di Leonardo Da Vinci: senza nulla togliere, i primi improvvisati ed imprecisi; il secondo, invece, simbolo di perfezione e genialità, capace di unire Arte e Scienza in opere senza eguali nella storia dell’Umanità.

La reazione per essere efficace dovrà, quindi, essere sinergica, ovvero non potrà essere il solo frutto di soluzioni scientifico-tecnologiche, o politiche o sociali; dovrà, invece, essere propria di un tessuto connettivale che manifesta la sua complessità a partire dalla ricchezza di perfezione ed armonia presente al livello più basso e fondamentale, quello del DNA. Come le dita di una mano, sfera politica, sociale, scientifica e tecnologica dovranno avere la capacità di stringere fra le mani la mela del peccato originale, quella dell’uso improprio della Scienza delle Informazioni e strapparla dall’albero prima che induca Adamo ed Eva a commettere quel peccato originale che condannò il genere umano all’uscita dal paradiso terrestre. Se è vero che il progresso non può essere ostacolato, è altrettanto vero che può essere ricondotto ad uno sviluppo che non produca danni per la Società Civile.

Il frutto del peccato è nella totale anarchia di Internet; se oggi tale anarchia minaccia la democrazia in un mondo virtuale che è quello della NET alle nostre porte si sta affacciando una minaccia ancora più grande che partendo dal cyberspazio approda e produce effetti nel mondo reale e fisico in cui spendiamo le nostre azioni.

Per meglio analizzare e comprendere scenari futuri possibili consideriamo alcuni tratti caratterizzanti delle prossime minacce, introducendo le Infrastrutture Informative Critiche in Sez. 1, l’Evoluzionismo Informatico in Sez. 2, le Nuove Metodologie di Analisi in Sez. 3, la situazione attuale relativa alle minacce informatiche ed alle possibili soluzioni in Sez. 4, le nuove fragilità genetiche dei numeri primi in Sez. 5, le conclusioni trattate nella Sez. 6.

2. Infrastrutture Informative Critiche e Cyberwarfare

La gran parte delle infrastrutture che presidiano i fondamentali settori delle società moderne, Economia, Energia, Trasporti, Telecomunicazioni, Salute sono dipendenti e interconnesse mediante sistemi di rete che garantiscono il corretto svolgimento della vita.

Tali reti devono permettere l’operatività della CNI (Critical Network Infrastructure) in normali condizioni di funzionamento, ma anche e soprattutto garantire un’adeguata capacità operativa in caso di eventi critici. Per il loro funzionamento, tali infrastrutture si basano sempre di più su sistemi di telecomunicazione.

Le Telecomunicazioni e l’Informatica sono l’elemento senza il quale non è possibile trasferire segnali, dati, informazioni, ovvero consentire il corretto coordinamento di risorse (umane o tecnologiche) locali e remote.

Le CNI, nonostante le specificità derivanti dalle loro diverse funzioni, si strutturano in sistemi di reti interconnesse che mostrano una serie di caratteristiche comuni:

a) la distribuzione capillare su tutto il Territorio ed il loro collegamento in un sistema di rete comporta:

- difficoltà di presidio di tutte le installazioni;

- elevata visibilità;

- potenziali problemi di coordinamento ed intercomunicazione;

b) la comune missione di servizio pubblico comporta:

- requisiti stringenti di disponibilità e affidabilità;

- caratteristiche di rapido intervento e ripristino a fronte di crisi;

- infrastrutture con requisiti di massima robustezza e sicurezza;

- potenziali ricadute sulla pubblica sicurezza;

c) la funzionalità verso utenti/clienti esterni, pubblici e privati richiede interoperabilità e comporta:

- elevato rischio di intrusione;

- necessità di punti d’accesso controllati e sicuri per comunicazioni multi-protocollo;

- importanti conseguenze economiche di un guasto/sabotaggio.

Diversi sono gli eventi che possono condizionare in parte o globalmente l’efficienza delle infrastrutture del singolo Paese o di più Paesi: eventi naturali (alluvioni, terremoti, eruzioni vulcaniche), eventi causati da azioni umane volontarie (terrorismo, cyber-crime) o involontarie (errori, omissioni), eventi legati all’ambiente (inquinamento, agenti chimici, incendi), eventi legati al non corretto funzionamento di componenti infrastrutturali (rottura di un macchinario, bug nel software, ecc.).

Fino ad un decennio fa, ognuna di queste infrastrutture poteva considerarsi come un sistema autonomo sostanzialmente indipendente, gestito da operatori verticalmente integrati. Per una serie di ragioni tale struttura si è profondamente modificata al punto che sempre di più le varie infrastrutture tendono ad essere interdipendenti, soprattutto a causa della condivisione del cosiddetto cyberspace, ovvero lo spazio virtuale prodotto dall’interconnessione di calcolatori, sistemi di telecomunicazioni, applicazioni e dati. Ciò comporta che un guasto - di natura accidentale o dolosa - in una di tali infrastrutture può facilmente propagarsi, con un effetto domino, ad altre infrastrutture amplificando i suoi effetti e provocando disfunzioni e malfunzionamenti anche ad utenti remoti, sia dal punto di vista geografico che funzionale, rispetto al punto ove si è verificato il guasto iniziale. È proprio in relazione a quanto appena detto che, negli ultimi tre anni, la Comunità Internazionale sta ponendo particolare enfasi sulle minacce asimmetriche di tipo cyber o informatico/telematico.

L’attuale scenario è caratterizzato, pertanto, sia da accresciute e differenziate minacce nei confronti delle CNI sia da un mutato contesto infrastrutturale che induce, a causa delle interdipendenze esistenti, nuove tipologie di vulnerabilità. Ciò impone una maggiore e diversa attenzione a tutti gli aspetti di protezione, sicurezza e robustezza sia specificatamente per ogni singola CNI, sia complessivamente ed unitariamente per l’insieme delle CNI nazionali.

In tale scenario la possibilità di possedere strumenti di analisi, modellazione, simulazione e formazione ad hoc relativamente a:

- protezione di CNI (Critical Network Infrastructure),

- Crisis Management,

- Reaction to disruption activities,

diventa di straordinaria utilità.

3. Evoluzionismo Informatico e Cyberwarfare

Gli ultimi trent’anni hanno rappresentato il palcoscenico dell’era dell’informazione digitale e dell’uso delle tecnologie informatiche a supporto della quasi totalità delle attività che giorno per giorno l’uomo pone in essere.

Nel settore dell’Information & Communication Technology (ICT) il progresso è stato di una tale rapidità che se ripercorriamo gli ultimi cinquant’anni ci rendiamo conto che potremmo avviare un corso di studi in antropologia informatica.

Le parole chiave sono state: uso, interazione, comunicazione, immersione, realtà immersiva condivisa, controllo remoto wireless(1) (2).

Il termine uso per l’informatica rappresenta la nascita della tecnologia stessa ovvero il computer sostituisce tutte le operazioni di office automation, fornendo un unico strumento integrato, in grado di offrire in modo facile e non time consuming tutto quanto necessario alle normali attività di una struttura operativa, da quella base come la famiglia, a quelle complesse come gli Enti Pubblici e le Grandi Aziende.

Col passare degli anni l’uso si raffina offrendo al fruitore sempre nuovi strumenti che ne migliorino l’interazione; in altre parole si risolve il problema che appare negli anni ottanta dello scorso secolo quando le tecnologie informatiche colgono un loro limite: apparire noiose.

L’uomo nonostante sperimenti nuove e più accattivanti forme di interazione con i computer ha ancora, però, un’esigenza primaria che deve soddisfare quando è posto davanti al computer stesso, ovvero la comunicazione con altri individui e la condivisione di dati, informazioni, strategie, obiettivi(3).

Così gli anni ’90 rappresentano la diffusione delle tecnologie legate alla comunicazione, ad Internet ed al web ed alle sue evoluzioni basate sull’intelligenza artificiale(4) (5) (6). Negli ultimi dieci anni del secolo scorso la realtà virtuale lascia gli incubatori tecnologici e gli ambienti di ricerca per diventare prodotti asserventi diversi ambiti dalla difesa, alla medicina, dai trasporti all’intrattenimento, etc.

In tale scenario, particolare interesse, assume la Cyberwarfare.

Il termine Cyberwarfare negli ultimi anni ha avuto una significativa evoluzione. Nella sua genesi tra gli anni ’60 e ’80 del secolo scorso, esso indicava l’uso dei computer per la conduzione di azioni di guerra elettronica in uno spazio virtuale detto cyberspazio. Tipicamente si trattava di azioni simulate al calcolatore il cui obiettivo principale era la dimostrazione di capacità nuove volte alla definizione di strategie innovative orientate a vision sempre più ampie. Alla fine degli anni ’80 ed all’inizio dei primi anni ’90 grazie alle intranet le azioni di cyberwarfare diventano non più locali, ma distribuite su un territorio via via sempre più ampio in relazione alla dimensione della rete interna. L’avvento di Internet nel ’90 ha permesso un ampliamento globale dello spettro di azioni di possibile conduzione in un teatro virtuale ormai non più georeferenziato.

A questo punto cosa dire del presente?

È evidente che le tecnologie informatiche di tipo immersivo, come la realtà virtuale e quelle della comunicazione come il web si stanno fondendo per creare nuove forme di ICT; infatti, in diversi ambiti si cominciano a vedere nuove forme di organizzazione, le cosiddette VO (Virtual Organization) o VN (Virtual Network) che utilizzano una nuova espressione di rete che non è più la NET (rete, come ad esempio InterNET) ma è piuttosto una GRID (griglia) [1]. Le GRID infatti, rappresentano il passo successivo alle net technology dove sulla rete non si troveranno solo informazioni, ma servizi, i cosiddetti web services; in altre parole, le reti non saranno più reti di computers e loro periferiche, bensì maglie di dispositivi elettronici, come ad esempio la strumentazione elettronica di un laboratorio, un oscilloscopio per test, fino alla lavatrice di casa, alla telecamera per videosorvegliare il bimbo nella stanza accanto, al sensore di pioggia che abbassa le tapparelle della propria casa. Nello specifico, per il settore difesa, ciò significa avere la capacità di estendere la supervisione di Aree Critiche di Interesse ed estendere/distribuire il comando su aree estremamente estese: a tale proposito si pensi alle tecnologie per il soldato del futuro, al comando di dispositivi/armi comandati via GSM o UMTS, sistemi di guida automatica o comandabili a distanza come satelliti o UAV, etc. Ciò significa, quindi, che dopo la realtà immersiva condivisa, per le nuove tecnologie e l’informatica sarà l’era del controllo. Quella che noi oggi chiamiamo realtà virtuale e ciò che rappresenta la realtà fisica si fonderanno in un unico ambito d’azione: non ci sarà da meravigliarsi se la prossima generazione di giovani studenti avrà il potere di comandare a distanza e senza fili l’ABS della macchina del loro professore di informatica attraverso un palmare per vendicarsi di una brutta interrogazione: sono le tecnologie RFID (Radio Frequency Identification) web controlled. Ma se tale tecnologia non fosse maneggiata a scopi pseudo-ludici come il caso precedente, ma per azioni di contrasto o reazione al Governo che non attua quanto richiesto? Si pensi a cosa potrebbe accadere se individui malintenzionati avessero attraverso Internet la capacità di controllare e comandare un dispositivo. È evidente che per dirottare un aereo da crociera e farlo schiantare sulla Casa Bianca o far deragliare un treno della metropolitana non ci sarebbe bisogno più di preparazioni e addestramenti di kamikaze, ma soltanto di esperti di tecnologie innovative in grado di violare i sistemi informatici, che oggi risultano tra l’altro particolarmente fragili.

Spero che tali riflessioni lascino meditare coloro i quali sono deputati a prendere delle decisioni relativamente a quali strategie di prevenzione e contrasto sia necessario porre in essere e soprattutto che essi individuino quali requisiti minimi e strumenti debbano avere coloro i quali svolgono attività di intelligence. È evidente che ad oggi azioni terroristiche di questo tipo sarebbero completamente fuori da ogni possibile controllo e/o gestione(7) (8).

Si rendono, pertanto, necessari, studi, analisi ed approfondimenti operativi atti proprio a cogliere i limiti della teoria del controllo che si affaccerà nel prossimo futuro al fine di poter effettuare una crescita ed uno sviluppo supervisionato che ne garantisca la sicurezza intrinseca a livello globale, ovvero a livello sistemico. In tale scenario un ruolo fondamentale è rivestito da un lato dai sistemi di modellazione e simulazione di sistemi complessi(9) (10) (11) (12) (13) (14) (15) (16) dall’altro dai sistemi informatici avanzati per il trattamento di informazioni basati sulle tecnologie GRID e sul Web semantico. Nello specifico, come vedremo, la realtà considerata assumerà un profilo di sempre maggiore complessità; inoltre, le suddette tecnologie implicheranno una sempre maggiore estensione della visione del contesto da considerare in uno scenario che diventa net-centrico, non sempre geo-referenziato e che richiede motori computazionali di tipo stocastico per la modellazione di fenomeni complessi come l’analisi comportamentale di chi opera in teatro sotto determinate sollecitazioni(17) (18) (19).

4. Nuove Metodologie di Analisi: cyberspazio - un possibile scenario di modellazione avanzata delle informazioni

Per meglio comprendere la complessità da trattare si consideri il seguente esempio che analizza la cyberwarfare in relazione ad azioni terroristiche.

Esistono molte definizioni di terrorismo e molteplici declinazioni in relazione all’aggettivo che lo accompagna come ad esempio terrorismo religioso, terrorismo informatico, etc.

Tali minacce asimmetriche nelle diverse forme hanno sempre un massimo comune denominatore che è rappresentato da:

- simbolismo;

- violenza a fini politici/sociali etc.;

- finalità intimidatorie;

- vittime civili che sperimentano una forte condizione di disagio.

Un’analisi generalista del terrorismo risulta tipicamente inadeguata, poiché esistono molteplici fattori peculiari, tipizzati e contestuali, nonché diversi parametri strutturali, di sostegno e finanziabilità dei gruppi terroristici.

A livello di analisi bisogna riconoscere che sono stati effettuati studi e ricerche per analizzare i suddetti aspetti in una visione sempre più ampia, ma i risultati sono a dir poco inadeguati non solo sul piano tecnico-tattico-operativo, ma addirittura sul piano metodologico. In [4], infatti, si considera come uno spazio quadridimensionale (ovvero 3 coordinate spaziali x ,y, z ed una temporale, il tempo t) sia inadeguato a descrivere lo spazio d’azione in cui operare, ma l’unico sforzo che si fa è quello di analizzare i fenomeni di interesse in uno spazio 5-dimensionale, dove la quinta dimensione è la c, che sta per cyber. Particolarmente utile in tali contesti potrebbe essere, invece, un approccio che tiene conto non solo dei parametri e degli indicatori in gioco, ma anche della loro dinamica evolutiva. A tale proposito un’analisi utile, con metodologie matematiche, è stata presentata in [5] dove si analizza la descrizione matematica di sistemi sociali ed economici, visti come network, utilizzando la teoria dell’informazione ed i sistemi dinamici. In [2], [3] l’autore del presente lavoro individua, altresì, una nuova ed avanzata metodologia di rappresentazione degli eventi che permette di comprendere l’essenza di un dato fenomeno e quindi svolgere attività inferenziali, come vedremo qui di seguito.

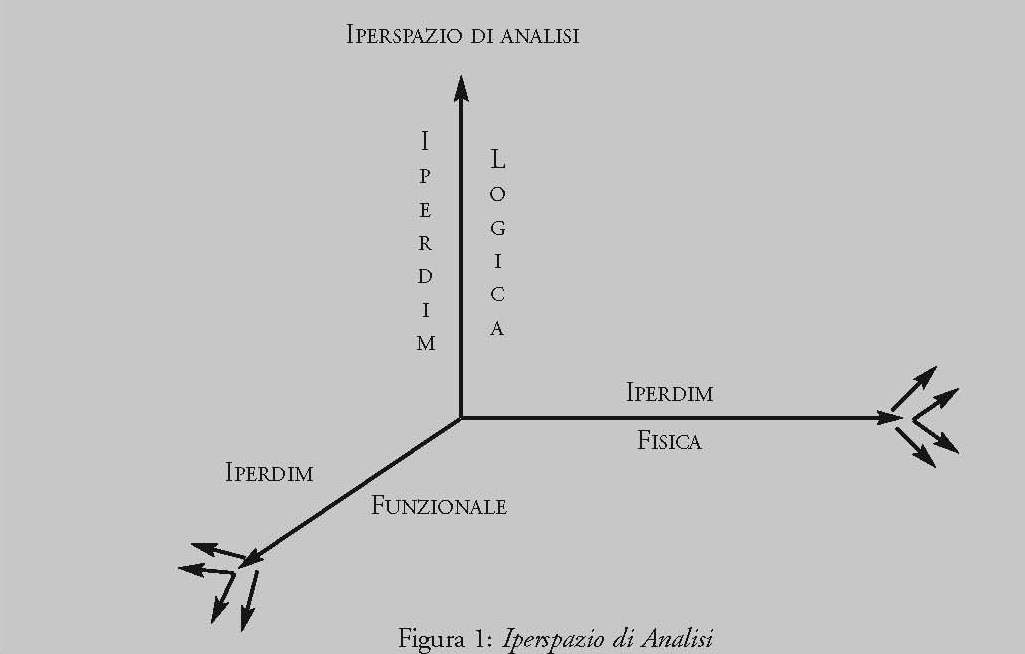

Da un punto di vista metodologico al fine di individuare strategie di contrasto ed analizzare in modo organico la molteplice e variegata complessità dei parametri in gioco è necessario effettuare un’analisi in almeno tre iper-dimensioni distinte:

- iper-dimensione fisica;

- iper-dimensione logica;

- iper-dimensione funzionale.

In tale scenario le iperdimensioni si caratterizzano con uno spazio a più dimensioni dove ad ogni dimensione è associato un parametro caratteristico.

Nel caso specifico della iperdimensione fisica ad essa può associarsi uno spazio a più dimensioni dove le singole componenti sono ad esempio il luogo, il tempo, l’estensione del fenomeno ed altri parametri di tipo strutturale come ad esempio l’orografia del territorio, etc.

Questa prima iperdimensione ha la funzione di georeferenziare, laddove possibile, il fenomeno individuando i fulcri per eventuali attività di network analysis.

La seconda iperdimensione è rappresentata anch’essa da uno spazio a più dimensioni dove le dimensioni, in questo caso, riguardano parametri che tengono conto di condizioni legate ad esempio a fattori storico-culturali, matrici religiose, background economico-finanziario, fine politico, grado di violenza criminale, livello di clandestinità.

La terza iperdimensione è, invece, rappresentata da uno spazio che analizza aspetti che mirano a costruire un quadro del modus operandi; in particolare, le diverse dimensioni dello spazio rappresentativo sono legate all’organizzazione funzionale del gruppo terroristico, alle modalità con cui preparano ed attuano le azioni terroristiche, alle modalità che riguardano le scelte degli obiettivi sensibili ed al rapporto costi/benefici relativamente alla massimizzazione dell’azione intimidatoria ed alla diffusione della paura nelle masse obiettivo dell’attentato.

Definiamo allora iperspazio lo spazio n-dimensionale strutturato e gerarchico le cui dimensioni sono rappresentate dalle tre precedenti iperdimensioni (vedi Figura 1).

Una tale analisi ha il vantaggio di poter avere una rappresentazione matematica che permette di effettuare valutazioni sia di tipo qualitativo, come accade con altri approcci, ma anche in più possiede un notevole potere espressivo da un punto di vista quantitativo: evitando così il conseguimento di risultati soggettivi. Infatti, se associamo ad ognuno dei parametri in gioco, rappresentato da una specifica dimensione del nostro iperspazio, un valore numerico x - i cui valori sono tra 0 ed 1 - ovvero se, saremo in grado di effettuare stime quantitative del fenomeno in studio, individuando così quali possono essere le migliori azioni di prevenzione e contrasto. Inoltre se, ad un tale metodo, che matematicamente rientra nei cosiddetti processi di fuzzificazione (ovvero quei processi che rimappano i valori possibili di una data grandezza in un intervallo 0,1), vi associamo una probabilità di accadimento, allora esso avrà il vantaggio di fornirci stime per l’inferenza di obiettivi da perseguire. In altre parole, se si associa al valore zero l’evento impossibile ed al valore uno l’evento certo avremo che un dato evento di probabilità intermedia avrà una possibilità P di incidere, data proprio dal valore percentuale assunto.

A tal punto per l’analisi di un dato fenomeno terroristico potranno utilizzarsi i classici strumenti della probabilità e della statistica inferenziale attraverso l’uso, ad esempio, di probabilità composte o condizionate per descrivere fenomeni o attività complesse in cui entrano in gioco più fattori contemporaneamente ovvero si potranno utilizzare metodologie matematiche innovative nate proprio per descrivere fenomeni complessi, stocastici e autosimilari come ad esempio i frattali, i processi dinamici stocastici autosimilari, le catene di Markov, l’analisi multiscala e multi-risoluzione. Attraverso tale approccio un dato evento diventa un punto a cui è associato un set di proprietà e probabilità in questo spazio a più dimensioni (l’iperspazio), che è sia uno spazio degli stati che uno spazio degli eventi. Viceversa un dato fenomeno terroristico sarà matematicamente rappresentato dall’insieme di transizioni da uno stato ad un altro, ovvero dalla traiettoria del fenomeno nell’iperspazio. L’analisi dei parametri legati a stati successivi da un punto di vista metodologico permetterà di effettuare sia analisi di contesto e di scenario (approccio deduttivo) che analisi di tipo previsionale (approccio induttivo - esperienziale simulato).

È facile comprendere che una tale metodologia ha il suo focus sull’evento e sulla sua dinamica; pertanto, da un punto di vista informatico esso trova subito una similarità con le tecniche di programmazione, cosiddette object oriented. Grazie agli strumenti innovativi dell’ICT, quindi, si potranno implementare le metodologie matematiche suddette, realizzando tool ad hoc per l’analisi e la previsione all’interno di una infrastruttura informatica innovativa e specialistica per l’attività di intelligence. È evidente, quindi, come un approccio siffatto sia più efficace da un punto descrittivo e predittivo rispetto a quelli tradizionali e permetta di individuare azioni di contrasto più efficienti rispetto ad analisi del fenomeno terrorismo di tipo più tradizionale, in cui si analizzano aspetti come le forme (ovvero terrorismo nazionalista e indipendentista o estremista o internazionale), o come le manifestazioni (ovvero contro i beni o le persone), etc.

5. Situazione Attuale della Cyberwarefare

È noto che nell’ambito della Scienza dell’Informazione la Sicurezza delle Informazioni si occupa della salvaguardia dei sistemi e delle informazioni trattate da potenziali rischi e/o violazioni dei dati. I principali aspetti di protezione del dato sono:

- la confidenzialità, ovvero possono fruire dell’informazione solo coloro i quali ne abbiano i privilegi di accesso;

- l’integrità, ovvero il dato deve essere protetto da manipolazioni e/o cancellazioni non autorizzate;

- la disponibilità, ovvero deve essere difeso il diritto/privilegio di coloro i quali siano abilitati ad usufruire delle informazioni messe loro a disposizione dall’amministratore/gestore.

La protezione dagli attacchi informatici viene ottenuta agendo su più livelli:

- livello Fisico, ovvero ponendo i server in luoghi il più possibile sicuri, dotati di sorveglianza e/o di controllo degli accessi;

- livello Logico, ovvero prevedendo l’autenticazione e l’autorizzazione dell’utente del sistema, prevedendo altresì diverse tipologie di utente con diversi livelli di sicurezza, di confidenzialità e disponibilità delle informazioni;

- livello Funzionale, ovvero a seguito dell’accesso - sia esso permesso che proibito - avere la capacità di effettuare un monitoraggio sulle azioni dell’utente, salvando i dati di tracciamento di quanto svolto in file di log. Questo processo di monitoraggio delle attività è generalmente indicato con i termini di audit o accountability.

Inoltre, si è soliti fare la distinzione tra:

- sicurezza passiva, ovvero l’insieme delle metodologie e tecnologie di tipo difensivo od anche il complesso di soluzioni il cui obiettivo è quello di impedire che utenti non autorizzati possano accedere a risorse, sistemi, infrastrutture, informazioni e dati di natura riservata; tale sicurezza si realizza operando soprattutto a livello fisico e logico;

- sicurezza attiva, ovvero l’insieme delle tecniche e degli strumenti mediante i quali le informazioni ed i dati di natura riservata sono resi intrinsecamente sicuri; ciòsi realizza proteggendo gli stessi sistemi ottimizzando delle funzioni obiettivo multiparametriche dipendenti dai principali parametri di protezione suddetti, ovvero confidenzialità, integrità, disponibilità.

Da quanto detto appare evidente che la sicurezza attiva e passiva rappresentano aspetti complementari per il raggiungimento di un unico obiettivo, ovvero la protezione di Infrastrutture Informative Critiche (IIC).

A seconda della tipologia di infrastruttura e/o dati da proteggere si adotteranno misure più o meno sofisticate di tipo attivo piuttosto che passivo al fine di ottimizzare funzioni obiettivo del tipo costi/benefici, massimizzazione/ottimizzazione della funzione sicurezza/disponibilità dell’informazione, ovvero confidenzialità/disponibilità, etc.

Le tecniche di attacco sono molteplici, perciò è necessario usare contemporaneamente diverse tecniche difensive per proteggere un sistema informatico. La strategia da adottare per difendersi è analoga a quella che può essere adottata in ambito militare, ovvero realizzare un numero di barriere via via crescente rispetto al livello di protezione da conferire al dato tra colui che pone in essere un attacco e l’obiettivo. Talvolta si tratterà di proteggere sistemi ed architetture informatiche altre volte si tratterà di difendere dati sensibili da coloro i quali non vi hanno accesso o ne hanno uno con bassi privilegi. A seconda dell’obiettivo avremo diverse tipologie di violazioni possibili, quali ad esempio:

- tentativi non autorizzati di accesso a dati/zone riservate;

- furto di identità digitale;

- furto di file riservati/sensibili;

- utilizzo fraudolento di risorse computazionali;

- denial of service (DoS), ovvero attacchi al sistema con l’obiettivo di rendere non utilizzabili alcune risorse in modo da danneggiare gli utenti del sistema.

La prevenzione viene gestita con tecnologie sia hardware sia software.

Dal momento che l’informazione è un bene che aggiunge valore alla collettività e che ormai la maggior parte delle informazioni sono custodite su supporti informatici, ogni organizzazione deve essere in grado di garantire la sicurezza dei propri dati, in un contesto dove i rischi informatici causati dalle violazioni dei sistemi di sicurezza sono in continuo aumento. A tale proposito è stato approvato a livello internazionale lo Standard ISO 27001:2005 finalizzato alla standardizzazione delle modalità adatte a proteggere i dati e le informazioni da minacce di ogni tipo, al fine di assicurarne l’integrità, la riservatezza e la disponibilità. Lo standard indica i requisiti di un adeguato sistema di gestione della sicurezza delle informazioni (ISMS) finalizzato ad una corretta gestione dei dati.

È importante anche distinguere tra minaccia ed attacco vero e proprio. Relativamente al rischio (minaccia) i due passi indispensabili nella progettazione di un Sistema Informativo sono:

- la valutazione del rischio;

- la gestione del rischio.

Quando il rischio diventa reale, ovvero allorquando si subisca un attacco, i passi fondamentali da porre in essere sono i seguenti:

- il monitoraggio continuo dell’intrusione/danni;

- l’analisi dei danni causati fino a quel momento;

- la stima dei danni in itinere;

- la valutazione inferenziale dell’obiettivo finale;

- la definizione delle misure di contrasto;

- l’attuazione delle misure di contrasto;

- il ripristino dei sistemi danneggiati;

- il ripristino globale del sistema;

- la messa in sicurezza ed esercizio del sistema.

Il problema della sicurezza Informatica è strettamente connesso con quello della sicurezza delle Infrastrutture Critiche Informative. In questa sezione siamo interessati alla sicurezza dei programmi e soprattutto dell’invio e ricezione di dati confidenziali protetti. Tale questione si è posta all’attenzione della Comunità Internazionale degli Esperti di software come conseguenza della sensibile crescita dell’uso degli strumenti informatici e di internet. In principio il termine sicurezza del software era inteso come l’assenza di condizioni conflittuali capaci di produrre danni mortali o irreparabili ad un sistema. Nella progettazione di software era quindi sufficiente raggiungere il compromesso più funzionale tra l’efficienza d’uso del programma in questione e la sua capacità di “sopravvivenza” all’uso e ad errori più o meno critici. Come visto in precedenza, oggi invece per sicurezza informatica intendiamo soprattutto la capacità di un sistema di resistere ad attacchi esterni che mirano a compromettere il suo funzionamento in modo più o meno grave. In ogni caso le due principali caratteristiche della sicurezza di un software sono sopravvissute, ovvero:

- safety (sicurezza): una serie di accorgimenti atti ad eliminare la produzione di danni irreparabili all’interno del sistema;

- reliability (affidabilità): prevenzione da eventi che possono produrre danni di qualsiasi gravità al sistema.

È allora evidente che un software è tanto più sicuro quanto minori sono le probabilità di successo di un guasto e la gravità del danno conseguente al guasto stesso.

L’ IEEE (Institute of Electrical and Electronics Engineers) ha catalogato gli errori nel software in tre diverse voci a seconda della natura degli errori stessi. Esse sono:

- error: è un errore umano verificatosi durante il processo di interpretazioone delle specifiche oppure durante l’uso di un metodo o nel tentativo di risoluzione di un problema;

- failure: è un comportamento del software imprevisto ed incongruo rispetto alle specifiche del programma stesso;

- fault: è un difetto del codice sorgente.

Il nuovo millennio è salito sul palcoscenico della storia con due termini millenium bug e hacking: il primo voleva rappresentare l’insieme delle emergenze informatiche che sarebbero derivate dal cambio delle quattro cifre nel conteggio degli anni; di fatto già i primi giorni del 2000 hanno visto la piena risoluzione della questione, che era stata pianificata e risolta ancor prima che creasse problemi. Addirittura forse le misure adottate superarono le reali necessità del problema. Viceversa i termini hacking e hacker sono diventati di dominio pubblico volendo individuare quell’insieme di minacce che minano la privacy, la salvaguardia delle informazioni e del loro uso.

Se è vero che l’Informatica rappresenta l’ultima avanguardia della Scienza e dell’Arte allora stiamo davvero assistendo ad una produzione di opere d’arte senza eguali nella storia del genere umano ed il cyberspazio rappresenta la cybercasa di Leonardo da Vinci. In realtà, oltre all’accezione negativa dell’hacking che abbiamo sperimentato in questi ultimi anni, ve ne è anche una estremamente positiva: infatti, in generale l’hacking si riferisce ad ogni situazione in cui si faccia uso di creatività e immaginazione nella ricerca della conoscenza. In altre parole, così come Leonardo può essere considerato un hacker del XV secolo in Ingegneria, Scienza e Architettura, così gli attuali hacker dovrebbero intendersi come gli Ingegneri della Conoscenza.

Se consideriamo la radice del termine hacker, si può osservare che essa è la forma sostantiva del verbo inglese to hack “tagliare”, “sfrondare”, “sminuzzare”, “ridurre”, “aprirsi un varco”, appunto fra le righe di codice che istruiscono i programmi software. Un hacker è, quindi, prima di tutto chi riduce la complessità e la lunghezza del codice sorgente, con un hack, appunto, una procedura grossolana ma efficace. In questa accezione positiva tra i Leonardo da Vinci dell’Informatica vanno sicuramente annoverati Richard Stallman - autore, tra gli altri, di Emacs e GCC, ideatore del concetto di Software libero e di copyleft, Eric S. Raymond - fondatore del movimento open source, scrittore di libri e saggi sulla cultura hacker, Johan Helsingius - che mantenne il più famoso anonymous remailer del mondo, finché non lo chiuse nel 1996, Tsutomu Shimomura - che aiutò l’FBI ad arrestare il famoso Kevin Mitnick che aveva eseguito alcune tra le più ardite incursioni nei computer del governo USA. Purtroppo, invece, negli ultimi anni i diversi Governi hanno dovuto sperimentare un’accezione diversa del termine hacker: esso ha assunto un significato negativo, poichè uscendo dall’ambito accademico il termine è diventato sinonimo di criminali informatici. Accanto al termine hacker si sono aggiunti i termini cracker e phreaking. Il termine cracker descrive colui che entra abusivamente in sistemi altrui e li manipola allo scopo di danneggiarli (cracking), lasciare un segno del proprio passaggio, utilizzarli come ponti per altri attacchi oppure per sfruttare la loro capacità di calcolo o l’ampiezza di banda di rete. I cracker possono essere spinti da varie motivazioni, dal guadagno economico (tipicamente coinvolti in operazioni di spionaggio o in frodi) all’approvazione all’interno di un gruppo di cracker. Il termine phreaking, invece, è il risultato dell’unione tra le parole phone (telefono) e freak (persona bizzarra) per descrivere piraterie telefoniche e quindi attività illecite di persone che sperimentano e sfruttano i telefoni, le compagnie telefoniche e sistemi che compongono o sono connessi alla Public Switched Telephone Network (PSTN).

L’hacking può essere visto come un puro strumento e come tale, a seconda di chi lo usa e del motivo per cui lo usa, può assumere valenze positive o negative.

La pratica di accedere illegalmente a sistemi altrui (per qualsivoglia motivo) usa mezzi e tecniche proprie dell’hacking, ma se ne differenzia profondamente: mentre l’hacker cerca la conoscenza, il cracker mira alla devastazione e al furto. Chi pratica l’intrusione informatica semplicemente copiando le tecniche trovate e sviluppate da altre persone sfruttando exploit già pronti, viene chiamato lamer o script kiddie.

Con il termine exploit si vuole identificare un metodo che, sfruttando un bug o una vulnerabilità del sistema, porta all’acquisizione di privilegi o al Denial of Service (DoS) di un computer. Un exploit locale richiede un preventivo accesso al sistema e solitamente fa aumentare i privilegi dell’utente oltre a quelli impostati dall’amministratore. Gli exploit possono anche essere classificati a seconda del tipo di vulnerabilità che sfruttano (buffer overflow, heap overflow, format string attacks, race condition, double free, integer overflow, sql injection, cross-site scripting e cross-site request forgery).

Lo scopo di molti exploit è quello di acquisire i privilegi di root su un sistema. È comunque possibile usare exploit che dapprima acquisiscono un accesso con i minimi privilegi e che poi li alzano fino ad arrivare a root. Normalmente un exploit può sfruttare solo una specifica falla e quando è pubblicato questa falla è riparata e l’exploit diventa obsoleto per le nuove versioni del programma. Per questo motivo alcuni blackhat hacker non divulgano gli exploit trovati ma li tengono riservati per loro o per la loro comunità. Questi exploit sono chiamati zero day exploit e scoprire il loro contenuto è il più grande desiderio per gli attacker senza conoscenze, altrimenti detti script kiddie.

Qui di seguito elenchiamo le principali vulnerabilità e tecniche utilizzate nella cyberware per attaccare sistemi informativi, rimandando ad altri scritti maggiori approfondimenti:

1) Buffer overflow;

2) Shellcode;

3) Cracking;

4) Backdoor;

5) Port scanning;

6) Sniffing;

7) Keylogging;

8) Spoofing;

11) Trojan;

12) Virus;

13) DoS (Denial of Service);

14) DDoS (Distributed Denial of Service);

15) Ingegneria sociale.

Le principali tecniche di difesa da attacchi ad Infrastrutture Informative Critiche (IIC) sono, invece, le seguenti:

1) Antivirus;

2) Anti-spyware;

3) Firewall;

4) Firma Digitale,

6) Watermarking;

7) Algoritmi di Crittografia;

8) Backup;

9) Honeypot;

10) Intrusion Detection System (IDS);

11) Network Intrusion Detection System (NIDS);

12) Sistema di autenticazione;

13) Sistemi biometrici di identificazione e riconoscimento.

6. Nuove probabili fragilità nei sistemi di protezione delle informazioni: la genetica dei Numeri Primi

Nonostante le contromisure elencate nel precedente paragrafo per fronteggiare gli attacchi ai sistemi informativi da parte di hacker o cracker, le minacce future potrebbero essere di portata notevolmente superiore a quelle attuali, colpendo profondamente la sicurezza intrinseca dei sistemi; tale fragilità è, infatti, legata alle fondamenta su cui sono basate le attuali tecniche di cifratura dell’informazione.

Una delle più famose questioni mai risolte nella storia della Matematica riguarda la distribuzione dei numeri primi. Tale problema è stato studiato fin dall’inizio delle Scienze Matematiche, al fine di comprendere se la successione dei numeri primi seguisse delle particolari regole o se viceversa l’apparire di un numero primo successivo ad un altro fosse del tutto casuale. Negli ultimi duecento anni le attività di ricerca finalizzate a dare risposta a tale questione si sono notevolmente intensificate, poiché si riteneva inaccettabile che la Matematica, prima per rigore formale tra le Scienze Esatte, poggiasse i suoi teoremi e dimostrazioni su fondamenti frutto del caso.

È a tutti noto, infatti, che i primi e l’aritmetica rappresentano le basi di tutte le Scienze Matematiche. Tenuto conto che, nonostante i grandi sforzi degli ultimi duecento anni, non era stata trovata risposta alla precedente questione, ovvero non era stato possibile individuare una metodologia che permettesse di trovare una regola deterministica per generare la sequenza dei numeri primi, con l’avvento dell’Informatica in particolare e della Scienza dell’Informazione in generale si è riteso opportuno e conveniente fondare le tecniche di sicurezza e cifratura su quella che potremmo definire la più antica “ignoranza epocale” se si scoprisse che i numeri primi non sono soggetti al caos, ma alla teoria della complessità. Molto spesso, infatti, la distinzione tra caos e complessità è evanescente e dinamicamente riallocabile. Il progresso della conoscenza, infatti, può definirsi proprio come la capacità di rendere metodologicamente interpretabile qualcosa che fino all’istante precedente era non chiaro, casuale, stocastico, non rispondente a regole e principi che permettano di inquadrare quel dato aspetto in un contesto più ampio e deterministicamente comprensibile.

Appare evidente allora la scelta della Comunità Internazionale di scegliere per la sicurezza e la segretezza delle informazioni qualcosa che seppure noto in principio, poi nella pratica avesse un’infinita complessità: i numeri primi per l’appunto. Ecco, quindi, che col passare degli anni e l’aumentare della necessità di sicurezza nelle Informazioni le applicazioni Matematiche e di Computer Science che sfruttano la primalità aumentano; crescono le tecniche di cifratura basate sui numeri primi, basti pensare ad algoritmi come RSA, XTR e ECC, DES, Triple DES, AES alla base della cifratura delle informazioni, della firma digitale, dei protocolli per lo scambio delle informazioni, per la codifica e cifratura di informazioni via satellite, fino ad arrivare, all’e-commerce, alla posta elettronica, alle cartelle sanitarie elettroniche, alle transazioni bancarie, etc.

A tal punto è naturale chiedersi: e se si scoprisse che il battito dei numeri primi non è causale come si crede? Molti sono stati gli scienziati che hanno raccolto tale sfida, ma nonostante i notevoli sforzi nello sviluppare i più complessi algoritmi e le più evolute tecniche tra le diverse branche dalla matematica la risposta fino al 2007 è stata sempre la stessa: le basi della Matematica, ovvero la generazione dei numeri primi, sembrano franare innanzi alle leggi del caos e lasciano il passo alla teoria dei processi stocastici.

Nel 2007, dopo circa un anno in cui mi aveva affascinato tale sfida, compresi che forse la risposta non era nel considerare teorie sempre più complesse, ma cambiare punto di vista(20). Si pensi ad esempio come appare oggi l’Universo nella sua interezza: è una distribuzione apparentemente casuale di materia; ma se, invece, si considerano le leggi della dinamica a cui i diversi sistemi materiali sono soggetti e quindi il processo deterministico che ci permette di tornare indietro nel tempo fino al big bang ecco che quella distribuzione di materia non appare più caotica e frutto di processi stocastici, ma deterministica e prevedibile. Allora se si provasse a condurre un ragionamento analogo, ovvero se la casualità dei primi fosse solo una complessità legata a molti, moltissimi, processi iterativi a partire da meccanismi che, invece, sono estremamente semplici?

Per dimostrare tali tesi è necessario:

- definire una nuova metodologia che ci permetta di scheletrizzare, attraverso un riduzionismo metodologico e non categorico, le intuizioni;

- costruire un apparato matematico in grado di dimostrare le intuizioni, trasformandole così in teoremi.

Per costruire una nuova vision lasciamoci guidare dai seguenti tre suggerimenti:

- “l’unico vero viaggio verso la scoperta non consiste nella ricerca di nuovi paesaggi, ma nell’avere nuovi occhi” (Marcel Proust, Alla ricerca del tempo perduto). Questo suggerimento ci indica che dobbiamo cambiare punto di vista, ovvero che nonostante le teorie utilizzate siano al top di eleganza e complessità, esse non sono utili a determinare la risposta al nostro problema;

- “quando le cose diventano troppo complicate, qualche volta ha un senso fermarsi e chiedersi: ho posto la domanda giusta?” (Enrico Bombieri, Medaglia Fields per la Matematica 1974). Il secondo suggerimento ci richiama alla semplicità e quindi: quale scelta migliore se non la numerazione binaria? Essa è la lingua dei computer, della logica binaria (vero, falso), della riproduzione (maschi e femmine), etc;

- “sottile è il Signore ma non malizioso” (Albert Einstein, Fine Hall Princeton). Questo terzo suggerimento risuona come un invito a ricercare la soluzione allo stesso modo di come fanno i fisici nella ricerca delle dinamiche delle fenomenologie naturali: i numeri primi sono gli atomi dell’aritmetica, a partire dai quali si possono costruire tutti gli altri numeri. Ciò significa definire nuove leggi di composizione e di scala estendendo le attuali conoscenze.

Il risultato di questa ricerca è stato di incredibile fascino poiché, come si vedrà, a partire dall’uomo che comincia la ricerca di una legge matematica che sia alla base della generazione dei numeri primi si trova che la risposta è nell’uomo stesso, nelle leggi della genetica e nei principi base dell’evoluzione e della genetica, una sorta di armonia e supersimmetria universale che vale dalle leggi matematiche di base fino all’estrema complessità della natura umana e delle fenomenologie naturali(21). Lo studio dei numeri primi attraverso la rappresentazione binaria mi ha portato a considerare i principi alla base dell’evoluzione umana e/o della genetica. Analizziamoli brevemente per costruire il genoma dei numeri primi.

1) la prima regola è l’esistenza di due distinti portatori di DNA, l’Adamo e l’Eva degli uomini, che nel nostro caso coincidono con i primi due numeri primi, 2 e 3;

2) la seconda regola è l’accoppiamento, che nel nostro caso facciamo corrispondere all’operazione di moltiplicazione, ottenendo il risultato 2 x 3 = 6; pertanto il 6 dovrà giocare un ruolo fondamentale nella storia evoluzionistica dei numeri primi;

3) dall’accoppiamento deriva la filiazione; pertanto, al variare di un parametro k avremo le diverse generazioni, ovvero per k = 1 i 6k rappresentano i figli di Adamo ed Eva, per k = 2 i nipoti e così via;

4) la quarta regola riguarda la differenziazione sessuale (o genetica se si parla di DNA): nel nostro caso guardando alla differenza tra il primo maschio e la prima femmina, 2 e 3 rispettivamente, si ottiene come risultato 3 - 2 = 1; pertanto i discendenti matematici maschi e femmine (di Adamo ed Eva) saranno del tipo 6k - 1 e 6k + 1 al variare di k nell’insieme dei numeri naturali, ovvero k N (e non gli asessuati 6k). A titolo di esempio si può verificare che considerando per k i valori 1, 2, 3, etc. la famiglia dei 6k - 1 fornirà i numeri 5, 11, 17 quali candidati alla primalità, mentre la famiglia dei 6k + 1 fornirà i numeri 7, 13, 19;

5) la quinta ed ultima regola riguarda la selezione naturale. Si pensi ancora all’evoluzionismo ed alla genetica: è a tutti noto che quando si accoppiano individui di una stessa famiglia il DNA prodotto diventa via via più debole. Nel nostro caso ciò vuol dire che all’interno delle famiglie 6k - 1 e 6k + 1 (i genotipi ovvero i candidati primi) dovremo scartare quei numeri che si ottengono dall’accoppiamento tra loro di due numeri della famiglia 6k - 1, tra due numeri della famiglia 6k + 1 e quei numeri ottenuti dall’accoppiamento di un numero della famiglia 6k - 1 ed uno della famiglia 6k + 1. Questo ragionamento nonostante l’apparente semplicità permette di generare la sequenza esatta dei numeri primi senza alcun errore. Infatti, come poi è stato dimostrato in [21], i numeri primi seguono esattamente le regole suddette. Nello specifico i numeri non primi (ovvero i numeri compositi) appartenenti alla famiglia dei 6k - 1 che dovranno essere scartati sono dati dal prodotto di un numero della famiglia dei 6k - 1 per uno della famiglia dei 6k + 1. Allo stesso modo i numeri da scartare nella famiglia dei 6k + 1 saranno dati dal prodotti di due numeri nella famiglia dei 6k - 1 o dal prodotto di due numeri della famiglia dei 6k + 1(22).

Quindi, non solo la Matematica è lo strumento per descrivere formalmente le fenomenologie naturali, ma vale anche il viceversa, ovvero le fenomenologie naturali sono la risposta e la dimostrazione dei fondamenti della Matematica stessa. Senza di essi, ovvero, senza l’analisi della vita dell’uomo e del suo evoluzionismo la Matematica avrebbe continuato a poggiare le sue basi sui primi, la cui generazione era ritenuta frutto del caso. Senza entrare nel dettaglio matematico che potrebbe apparire non adeguato al presente articolo possiamo affermare che quanto mostrato è solo l’inizio di una nuova visione. In altre parole, la metodologia proposta può essere reiterata per ottenere quelli che matematicamente potremmo chiamare acceleratori numerici. Ciò vuol dire che la proprietà trovata a partire dal prodotto dei primi due numeri primi (ovvero 2 e 3), può essere iterata, ovvero possiamo moltiplicare i primi tre numeri primi (ovvero 2, 3, 5) e poi ancora i primi quattro numeri primi (ovvero 2, 3, 5, 7).

Operando in questo modo avremo un generatore di numeri candidati alla primalità che si comporta come un setaccio che diventa via via sempre più selettivo, ovvero genera numeri primi che sono via via sempre più distanti. Ciò è proprio quanto accade generalmente nella realtà, ovvero i numeri primi diventano via via sempre più radi allorquando si proceda alla generazione o alla relativa scoperta.

Se da un punto di vista scientifico tale risultato è avvincente e da un punto di vista filosofico estremamente affascinante, da un punto di vista delle applicazioni apre un nuovo orizzonte di studi e soluzioni da determinare; dal punto di vista della sicurezza delle informazioni implica una intrinseca fragilità dei sistemi di cifratura a cui bisognerà tempestivamente trovare nuove soluzioni. Infatti, si pensi se qualcuno avesse la possibilità di accedere ai database di una banca e trasformare i crediti in debiti, oppure di trasformare il significato semantico di una frase, scambiando i termini o il locus di parole all’interno di una frase. Significherebbe che se quelle informazioni rappresentano la codifica di ordini o funzioni da svolgere, chi riceve quel comando agirebbe in modo contrario a quanto voluto. La stessa firma digitale perderebbe significato, così come le transazioni bancarie per l’e-commerce. In altre parole il cyberterrorismo avrebbe in mano lo strumento più potente per distruggere il libero mercato, le transazioni bancarie, il trasferimento delle informazioni. Si tratterebbe di attacchi non più a livello sistemico, logico o funzionale, ma a livello genetico, a livello core.

7. Conclusioni

Così come oggi è stato scoperto il DNA dei numeri primi, non ci vorrà molto prima che nasca l’Ingegneria Genetica dei Numeri Primi e l’equivalente numerico delle cellule staminali e della clonazione. È, pertanto, necessario determinare soluzioni a tale problema e definire nuove strategie di prevenzione e contrasto ad attacchi di cyberterrorismo. Tali soluzioni ancora una volta non dovranno essere solo tecnologiche o scientifiche, ma anche politiche e sociali, altrimenti il progresso della conoscenza sarà esso stesso il Cavallo di Troia con cui sconfiggerci.

Nel prossimo futuro, pertanto, relativamente all’evoluzione del concetto di controllo, precedentemente citato, non solo le Infrastrutture Informative Critiche ma la Collettività stessa potrebbero sperimentare minacce ed attacchi a livello sistemico che partendo dal mondo virtuale arrivino direttamente ad agire su quello reale da un lato, e dall’altro relativamente al DNA dei numeri primi si potrebbe assistere a minacce e aggressioni sull’informazione a livello genetico, ovvero fondamentale, che sono in grado di minare stati patrimoniali, libera comunicazione, trasmissione di informazioni riservate e tanto altro.

Relativamente al primo punto l’uso di nuove metodologie e tecnologie matematiche ed informatiche saranno il punto di partenza, così come relativamente alla fragilità dei sistemi basati sulla primalità, la Biometria e la Meccanica Quantistica saranno i primi strumenti che avranno gli esperti per affrontare il problema della sicurezza da un punto di vista scientifico-tecnologico. Dal punto di vista dello strumento militare bisognerà porre in essere strategie basate su nuove metodologie e tecnologie atte alla prevenzione ed al contrasto di nuove cyberminacce. Altrettanto difficile se non più complicato sarà l’impegno politico e del legislatore: essi si troveranno ad operare scelte coraggiose ed apparentemente impopolari per la salvaguardia delle informazioni e del buon funzionamento delle Infrastrutture Critiche del Paese in primis, ma anche della Comunità stessa. Si comprende, quindi, anche il perché dell’uso della chiamata in causa del contesto sociale: sociale perché sarà necessario educare la popolazione all’uso corretto delle nuove tecnologie e delle scelte operate dalla politica per preservare la Collettività a volte anche sacrificando la libertà del singolo o limitando ciò che oggi chiamiamo libertà d’azione o il libero mercato, quando ciò rappresenti una minaccia per la Collettività stessa.

Approfondimenti

(1) - G.Iovane, Metodi Matematici e Tecnologie Innovative per la Prevenzione ed il Contrasto al Terrorismo, ISBN 978-966-2932-17-1, O. Vlasiuk publishing house, Vinnytsia, Ucraine, 2007.

(2) - G.Iovane, La Ricerca Tecnologica e l’Innovazione per la prevenzione ed il contrasto di azioni terroristiche: situazione italiana, internazionale e prospettive, LIF 58a Sessione IASD - 6a Sessione Speciale, Anno Accademico 2006-2007.

(3) - M.Gaeta, G. Iovane, A. Makarenko, Information theory and possible mathematical description of economical and social systems based on real physical phenomena, System Research and Informational Technologies, n. 4, pagg. 52-64, 2005.

(4) - F. Magrino, Sette chiavi per il futuro - nuovi materiali e tecnologie per il 2000, Edizioni del Sole 24 ORE, 1988.

(5) - P. Battaglia, L’intelligenza artificiale, dagli automi ai robot intelligenti, UTET, 2006.

(6) - S.J. Russel and P. Norvig, Intelligenza Artificiale, Vol. 1 e Vol. 2, Pearson Education Italia, 2005.

(7) - U. Rapetto, R. Di Nunzio, Le Nuove Guerre, Bur, 2001.

(8) - E. Halpin, P. Trevorrow, D. Webb, S. Wright, Cyberwar, Netwar and the Revolution in Military Affaire, isbn 10: 1-4039-8717-3, Palgrave Macmillan, 2006.

(9) - G. Iovane, Evoluzione dei concetti applicativi dei sistemi di Modeling & Simulation (M&S) e possibili architetture distribuite finalizzate alla sinergica utilizzazione di risorse in ambito nazionale, alleato ed europeo, Ricerca CeMiSS 2007.

(10) - A. Hausrath, Venture Simulation in War, Business and Politcs, McGraw-Hill, 1971.

(11) - S.J. Cross, A.S. Helsdingen, K. van den Bosch, Simulation - Indispensible training and assessment aid for ship handling and combat systems employment, Naval Force, International Forum for Maritime Power, No. II, 2003, issn 0722-8880.

(12) - C. Weirauch, US Air Force - Agency for Modeling and Simulation, MS&T, The International Defence Training Journal, Issue 5, pagg. 8-10, 2003.

(13) - F. Castagnetti, Centri di Simulazione e di Addestramento al Combattimento, Rivista Militare, Vol/Num.: 4, pagg. 92-99, 2000.

(14) - M. Trevisani, La simulazione operative ed addestrativa. Stato e realtà nell’ambito delle FF.AA. italiane, LIF 48a Sessione IASD, Anno Accademico 1996-1997.

(15) - L. Callini, Organizzazione di un centro di simulazione a supporto delle attività di pianificazione e delle attività operative dello S.M.D., LIF 49a Sessione IASD, Anno Accademico 1997-1998.

(16) - M. Coccia, Warfare simulation nel teatro Mediterraneo: un modello globale di simulazione operativa per l’Italia, alla luce delle esigenze strategiche e delle possibilità offerte dalla tecnologia più avanzata, Rivista Militare, Centro Militare di Studi Strategici, 1990.

(17) - D. Kemp, Network-Centric Simulation, Janès Defense Weekly, Vol. 41, No. 39, pagg. 39-45, 2004.

(18) - D. D’Ambrosio, Il Network Centric Warfare: Una soluzione idonea per gestire i conflitti, Rivista Militare, n. 2, pagg. 74-81, 2006.

(19) - G. Iovane, O. Kapustyan, Random dynamics of stochastically perturbed evolution inclusion and problem of distribution of power in military structure, Journal of Automation and Information Sciences, (Russian version) 4, 122-134, 2006, in press English Version, 2006.